英特尔Xeon 6:AI 6的新时代:云和当地的双重跳跃

- 编辑:admin -英特尔Xeon 6:AI 6的新时代:云和当地的双重跳跃

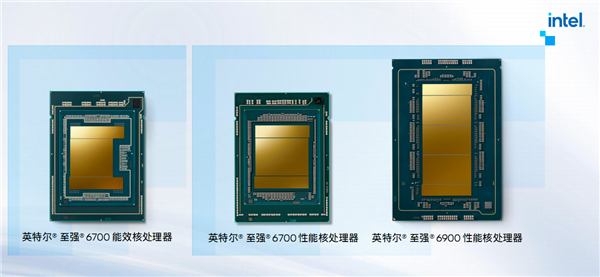

在过去的三年中,问题和答案的AI趋势,生成器和AI AI的增加和流动,这使整个技术行业进行了重组。特别是,数据中心是深厚的基本面和大型市场,正在经历前所未有的变化。 AI时代的数据中心不仅显示出计算机功率的繁荣,而且新需求不断唤醒和不断发展。例如,使用加速硬件和标准软件打开以满足高级计算机电源要求,包括对高级性能的明确要求以及从更稳定,可靠和兼容的角度来看的最严格要求。最突出的矛盾是数据中心能源消耗的迅速增加。预计全球数据中心将在2026年消耗germany的年度电力。这对能源效率和TCO成本有明确的要求,以及基础设施的TCO成本,这是有要求的,这些要求使可持续发展成为前所未有的重要性。在AI数据中心,不仅高性能GPU加速器,而且在中心中始终在新情况下也显示出新方面的CPU处理器。 [AI时代的Xiang 6再次出现]英特尔的新Xeon 6 Family考虑了AI数据中心的新需求,从硬件设计到技术特征。 Xeon 6在家族史上首次分为两组。 Xeon6900E/6700E系列使用电子核能源效率核,而Xeon 6900P/6700P/6500P/6300P系列使用P-核性能核。作为216 MB中的Flakelevel 3)或128个性能核(504 MB的3级),并支持12个内存通道,96个PCIE 5.0/CXL 2.0通道和6个UPI 2.0链接。 Xeon 6700/6500系列提供多达144个能源效率核或86个性能中心,并允许8个存储通道,88个PCIE 5.0/CXL 2.0通道和6个UPI 2.0链接。如此丰富的Skuo产品组合可以公平e不同类型的AI加速系统可以准确地满足不同的客户需求。在技术方面,Xeon 6系列的DDR5内存最多可容纳6400mt/s,与上一代相比,带宽增加了1.7倍,而第一个版本则允许新的MRDIMM内存。 Xeon 6900系列可提供多达12个内存频道,并且内存高达8800mt/s,这意味着带宽增加了2.3次,这使您可以更好地满足田野宽度IA的田野宽度的巨大需求。 PCIE 5.0带来了更大的I/O带宽,并增加了1.2倍。 UPI 2.0提供较大的多重带宽,增加1.8倍。接纳CXL 2.0,它允许记忆容量和更大的带宽。此外,在过去,几代Xeon不断整合了各种IP加速器,适用于各种服务,包括QAT数据保护和DSA压缩加速器,DAA数据流中的DAA数据流加速器动态负载分析和DLB加载加速器,DLB负载加速器,IAA数据保护加速器,IAA数据加速器,IAA附件加速器中的加速器。 ,如果被压缩和解压缩,则对应于约6.8 CPU核,但是Xeon 6具有四个QAT Incorporated,这使其可以下载CPU核的计算机功率24-32。此外,作为集成到CPU的IA加速器,高级AMX矩阵的扩展加速器正在极大地提高CPU的处理能力。借助AMX支持,Xeon 6 128核心的INT8计算机功率可以达到512个顶部,而BF16/FP16浮点功率也具有256个顶部。这是传统AVX-512传统AVX-512的说明的8次和16倍。在各种工作负载,尤其是AI负载中,Xeon 6系列可以在保持相似或较低的能源消耗的同时提供显着的性能改进。 Xeon 6900p系列的艺术家包括通用计算机科学,Web服务,科学计算和IA在内的领域的ITET。每瓦的性能的改进通常比上一代的Xeon Platinum 8592以上的两倍好,并且每瓦的性能通常要高1.4倍。有趣的是,作为CALL2-7B消化产生(BF16格式),IA领域的性能和能源效率的最大改进是。 Xeon 6900p系列可以在三次以上提高性能,并且瓦特性能也不错。如果两者都是64个核,那么与以前的Xeon Platinum 8592+相比,Xeon 6700p系列可以吸引到20%左右的潜在性能客户,其能耗基本相同,甚至更低。 Xeon 6700p系列具有高达86个核,超过了上一代的核,但其能耗尚未提高,并且性能可以提高40-50%。用于云计算Pplications,Xeon 6系列也是一个不错的选择,有效地提高了能量性能和效率,并大大降低了成本。与第五世代相比,Xeon 6系列可以实现核心密度的改进,单一的核心性能提高和60%的功率消费改进,最后在云计算领域贡献了大约30%的TCO代际成本成本收益。实际上,Xeon 6系列也是AI加速系统主CPU的理想选择。英特尔和Nvidia也在紧密合作。 Xeon 6系列通过双方共同努力,完全满足了NVIDIA MGX和HGX AI加速系统的要求。具有1/2 CPU和16/4/16 GPU的灵活性。 CPU可以作为32核的Xeon 6737p,64个核的Xeon 6761p/6767p和72个核的Xeon 6960p(可以将其配置为48个核心以增加频率)。最新的NVIDIA DGX B300系统专门选择646p Xeon 64p双通道核,例如主对照CPU。像72个核的Xeon 6962p和64个核心的Xeon 6774p一样,IASE中的主要加速度系统是由Intel专用于Intel设计的独家ESP模型,用于控制CPU。当然,其他Xeon 6系列模型也可以与AI加速度系统(包括能源效率核心系列)一起使用。 [火山电机的第四代EC的示例:全屏Xeon 6 by Force] Xeon 6系列不仅是传统数据中心的最佳选择,而且是AI加速系统的理想解决方案,许多客户都积极采用,以及这套独特的好处。例如,火山引擎已与英特尔密切合作,为核心性能核心处理器Xeon 6的弹性计算(ECS)第四代(ECS)实例启动。DPU和自身开发的服务器的自我开发服务器以及自我开发的服务器实现了全面的改进,并提供了A的全面改进,并提供了A A ENCELENS强大的支持负载电荷负载的快速增长。 Volcá运动家族Fourth Generation Nicos ECS包括G4i基本示例,示例的示例G4IE具有能量和G4IL示例,并改善了I/O。所有这些都在Xeon 6系列中取得了重大的性能提高。典型的互联网方案,密集的功率设置或I/O聚合方案,最大的改进可以达到30%。此外,已经详尽地更新了第四代EC的网络容量和存储。例如,通用网络和存储带宽增加了100%,PIO和PPS性能提高了30%,CPU频率也提高了20%。除了改善常见方案的性能外,火山引擎还为AI相关应用程序提供了详细的优化。根据最近的第四代EC,火山电机和英特尔与RA应用程序的详细优化相结合。 eff概念性地为四个关键链接的抹布应用程序执行了完整的链路速度,包括文档处理负载,集成矢量化,恢复向量数据库以及充分利用Xeon 6处理器的AMX加速器,从而大大减少了每个链接的任务时间和减少90%的任务时间。 WDL模型的推断还用深度优化在ON 6系列处理器中进行了Xecet。 WDL是推荐系统和广告交付中广泛使用的经典模型,该模型由广泛的(宽)模型和深度(深)模型组成。其中,广泛的模型负责捕获低阶特征的组合,例如用户点击的历史行为,从而提高了已知模式的记忆能力。深度模型通过非线性转换了解了高级秩序特征的组合,它利用了用户兴趣与属性之间的潜在关系产品的数据,并执行数据的广义表示。随着互联网用户继续扩展,搜索建议方案中的数据量呈指数增长,大大增加了对计算机能源的需求,但不能同时提高效率。面对这一挑战,火山和英特尔发动机进行了详细的调查。 AMX加速器优化导致了WDL模型推理性能的质量飞跃,从而提高了高达114%的性能能力,从而显着提高了模型推断的效率。此外,对于云阶段,火山发动机还建立了完整的末端 - 端链路安全解决方案。首先,根据Capablecpu TDX和GPU CC的说法,火山发动机在固件,核,虚拟化和操作系统中提供了全面而详细的优化,以最大程度地减少性能的影响。其次,火山引擎提供了许多安全功能,Such作为机密容器,密钥管理,参考管理,远程测试,安全延迟,数据预处理和数据之后的数据,以保护使用中的AI数据的安全性。 [Xiangqiang Ruixuan GPU的CPU合作伙伴:AI多合一的合作伙伴已经开始在Great AI型号的当地机器中实施大量的2B和2C服务,此外,除了云服务外,还具有更多的应用程序方案。在这方面,英特尔不仅具有CPU Xeon处理器,而且具有独特的特征。两个合作伙伴是智能的形式,这是一台机器,全部在Superio Computer Sciencea之一中,极大地提高了当地私有化推论的效率,并鼓励了业务和业务应用程序的创新。特别是,DeepSeek领导的开源模型的支持大大降低了AI中的所有人的技术阈值,这在很大程度上鼓励了加速采用。通常,机器或典型的Intel AI AI工作使用Xeon CPU,并且与1-4 Ruixuan GPU结合使用。其中,GPU可以选择启动的Ruixuan A770 16GB,以及新推出的Ruixuan Pro B60 24GB。我相信每个人都听说过AI应用程序中的视频记忆需求。大型视频内存可以显着改善AI应用程序和规模应用程序场景的性能,包括具有较大参数尺度,上下文长度和更多同意的较大模型支持。 Lanzar在台北计算机展上的Ruixuan Pro B60端,许多合作伙伴已经推出了各种产品解决方案。例如,Asus,Asus,Blue Ji,Mingxuan,Hanyu和骄傲的Turbo粉丝,Senao的开放式粉丝,Mingxuan创建了双GPU,提供多达48 GB的图形记忆。进行本地推断时,即使在量化之后,也通常很难处理具有大型参数的大型模型。例如,由INT8量化的DeepSeek-R1 32B蒸馏模型很容易被食用超过32 GB的视频记忆。它单个图形卡如何增加视频的内存都没有关系,空间并不是无限的。因此,毫无疑问,多张卡的并行性是理想的解决方案,并且由于众多开源软件的支持,多张卡的基础通信不再是问题。英特尔拥有自己的多-T通信库库库莎丽特。 4件Ruixuan A770可以提供64 GB的平行视频存储器,实质上是执行完整的32B型号或量化的型号70B。四个Ruixuan Pro B60并行,最多具有96 GB的视频内存,这使得在大型模型中本地运行变得更加容易。有了足够大的视频内存,企业提供了灵活性来配置AI应用程序所需的上下文或并发扩展。过去的单个上下文的长度在过去只有10k,但现在32K非常普遍。许多大型型号已经实现了数百个K或1M,对视频记忆容量的需求是Al因此迅速增加。这四张卡可以并行实现出色的96 GB视频记忆。这很容易填充,例如同时分析数百个文件信息页面。当固定上下文长度相似时,同时扩展。随着每个会话产生大量的KV缓存和历史记录,视频内存需求会大大增加,并且卡甚至无法处理33 GB的大尺寸。模型中的单个同时性和四个字母可以同时满足50个同时性的实例。总而言之,在新的AI时代,GPU加速器不仅引起了很多关注,而且还吸引了公司投资方法。但是,作为计算机系统的指挥中心,CPU处理器的重要性不仅减少了,而且越来越突出。您还必须仔细选择和优化以释放AI加速度系统的全部力量。自成立以来,Xeon 6系列已考虑到加速AI应用程序的优化。无论是云还是地方,都为该行业带来了新的活力,从而实现了新的会变和能源效率。特别是,新的产量和能源效率核的设计以及诸如MRDIMM内存和AMX加速器改进之类的独家支持,都为Xeon 6带来了广泛的应用空间。随着Intel行业的广泛和广泛的合作,Xeon 6的各种客观设计的各种客观设计都可以满足云层的需求。 [本文的结尾]如果您需要重印,请务必向我们展示其来源:Kuai技术编辑:Shangfang Wenq

在过去的三年中,问题和答案的AI趋势,生成器和AI AI的增加和流动,这使整个技术行业进行了重组。特别是,数据中心是深厚的基本面和大型市场,正在经历前所未有的变化。 AI时代的数据中心不仅显示出计算机功率的繁荣,而且新需求不断唤醒和不断发展。例如,使用加速硬件和标准软件打开以满足高级计算机电源要求,包括对高级性能的明确要求以及从更稳定,可靠和兼容的角度来看的最严格要求。最突出的矛盾是数据中心能源消耗的迅速增加。预计全球数据中心将在2026年消耗germany的年度电力。这对能源效率和TCO成本有明确的要求,以及基础设施的TCO成本,这是有要求的,这些要求使可持续发展成为前所未有的重要性。在AI数据中心,不仅高性能GPU加速器,而且在中心中始终在新情况下也显示出新方面的CPU处理器。 [AI时代的Xiang 6再次出现]英特尔的新Xeon 6 Family考虑了AI数据中心的新需求,从硬件设计到技术特征。 Xeon 6在家族史上首次分为两组。 Xeon6900E/6700E系列使用电子核能源效率核,而Xeon 6900P/6700P/6500P/6300P系列使用P-核性能核。作为216 MB中的Flakelevel 3)或128个性能核(504 MB的3级),并支持12个内存通道,96个PCIE 5.0/CXL 2.0通道和6个UPI 2.0链接。 Xeon 6700/6500系列提供多达144个能源效率核或86个性能中心,并允许8个存储通道,88个PCIE 5.0/CXL 2.0通道和6个UPI 2.0链接。如此丰富的Skuo产品组合可以公平e不同类型的AI加速系统可以准确地满足不同的客户需求。在技术方面,Xeon 6系列的DDR5内存最多可容纳6400mt/s,与上一代相比,带宽增加了1.7倍,而第一个版本则允许新的MRDIMM内存。 Xeon 6900系列可提供多达12个内存频道,并且内存高达8800mt/s,这意味着带宽增加了2.3次,这使您可以更好地满足田野宽度IA的田野宽度的巨大需求。 PCIE 5.0带来了更大的I/O带宽,并增加了1.2倍。 UPI 2.0提供较大的多重带宽,增加1.8倍。接纳CXL 2.0,它允许记忆容量和更大的带宽。此外,在过去,几代Xeon不断整合了各种IP加速器,适用于各种服务,包括QAT数据保护和DSA压缩加速器,DAA数据流中的DAA数据流加速器动态负载分析和DLB加载加速器,DLB负载加速器,IAA数据保护加速器,IAA数据加速器,IAA附件加速器中的加速器。 ,如果被压缩和解压缩,则对应于约6.8 CPU核,但是Xeon 6具有四个QAT Incorporated,这使其可以下载CPU核的计算机功率24-32。此外,作为集成到CPU的IA加速器,高级AMX矩阵的扩展加速器正在极大地提高CPU的处理能力。借助AMX支持,Xeon 6 128核心的INT8计算机功率可以达到512个顶部,而BF16/FP16浮点功率也具有256个顶部。这是传统AVX-512传统AVX-512的说明的8次和16倍。在各种工作负载,尤其是AI负载中,Xeon 6系列可以在保持相似或较低的能源消耗的同时提供显着的性能改进。 Xeon 6900p系列的艺术家包括通用计算机科学,Web服务,科学计算和IA在内的领域的ITET。每瓦的性能的改进通常比上一代的Xeon Platinum 8592以上的两倍好,并且每瓦的性能通常要高1.4倍。有趣的是,作为CALL2-7B消化产生(BF16格式),IA领域的性能和能源效率的最大改进是。 Xeon 6900p系列可以在三次以上提高性能,并且瓦特性能也不错。如果两者都是64个核,那么与以前的Xeon Platinum 8592+相比,Xeon 6700p系列可以吸引到20%左右的潜在性能客户,其能耗基本相同,甚至更低。 Xeon 6700p系列具有高达86个核,超过了上一代的核,但其能耗尚未提高,并且性能可以提高40-50%。用于云计算Pplications,Xeon 6系列也是一个不错的选择,有效地提高了能量性能和效率,并大大降低了成本。与第五世代相比,Xeon 6系列可以实现核心密度的改进,单一的核心性能提高和60%的功率消费改进,最后在云计算领域贡献了大约30%的TCO代际成本成本收益。实际上,Xeon 6系列也是AI加速系统主CPU的理想选择。英特尔和Nvidia也在紧密合作。 Xeon 6系列通过双方共同努力,完全满足了NVIDIA MGX和HGX AI加速系统的要求。具有1/2 CPU和16/4/16 GPU的灵活性。 CPU可以作为32核的Xeon 6737p,64个核的Xeon 6761p/6767p和72个核的Xeon 6960p(可以将其配置为48个核心以增加频率)。最新的NVIDIA DGX B300系统专门选择646p Xeon 64p双通道核,例如主对照CPU。像72个核的Xeon 6962p和64个核心的Xeon 6774p一样,IASE中的主要加速度系统是由Intel专用于Intel设计的独家ESP模型,用于控制CPU。当然,其他Xeon 6系列模型也可以与AI加速度系统(包括能源效率核心系列)一起使用。 [火山电机的第四代EC的示例:全屏Xeon 6 by Force] Xeon 6系列不仅是传统数据中心的最佳选择,而且是AI加速系统的理想解决方案,许多客户都积极采用,以及这套独特的好处。例如,火山引擎已与英特尔密切合作,为核心性能核心处理器Xeon 6的弹性计算(ECS)第四代(ECS)实例启动。DPU和自身开发的服务器的自我开发服务器以及自我开发的服务器实现了全面的改进,并提供了A的全面改进,并提供了A A ENCELENS强大的支持负载电荷负载的快速增长。 Volcá运动家族Fourth Generation Nicos ECS包括G4i基本示例,示例的示例G4IE具有能量和G4IL示例,并改善了I/O。所有这些都在Xeon 6系列中取得了重大的性能提高。典型的互联网方案,密集的功率设置或I/O聚合方案,最大的改进可以达到30%。此外,已经详尽地更新了第四代EC的网络容量和存储。例如,通用网络和存储带宽增加了100%,PIO和PPS性能提高了30%,CPU频率也提高了20%。除了改善常见方案的性能外,火山引擎还为AI相关应用程序提供了详细的优化。根据最近的第四代EC,火山电机和英特尔与RA应用程序的详细优化相结合。 eff概念性地为四个关键链接的抹布应用程序执行了完整的链路速度,包括文档处理负载,集成矢量化,恢复向量数据库以及充分利用Xeon 6处理器的AMX加速器,从而大大减少了每个链接的任务时间和减少90%的任务时间。 WDL模型的推断还用深度优化在ON 6系列处理器中进行了Xecet。 WDL是推荐系统和广告交付中广泛使用的经典模型,该模型由广泛的(宽)模型和深度(深)模型组成。其中,广泛的模型负责捕获低阶特征的组合,例如用户点击的历史行为,从而提高了已知模式的记忆能力。深度模型通过非线性转换了解了高级秩序特征的组合,它利用了用户兴趣与属性之间的潜在关系产品的数据,并执行数据的广义表示。随着互联网用户继续扩展,搜索建议方案中的数据量呈指数增长,大大增加了对计算机能源的需求,但不能同时提高效率。面对这一挑战,火山和英特尔发动机进行了详细的调查。 AMX加速器优化导致了WDL模型推理性能的质量飞跃,从而提高了高达114%的性能能力,从而显着提高了模型推断的效率。此外,对于云阶段,火山发动机还建立了完整的末端 - 端链路安全解决方案。首先,根据Capablecpu TDX和GPU CC的说法,火山发动机在固件,核,虚拟化和操作系统中提供了全面而详细的优化,以最大程度地减少性能的影响。其次,火山引擎提供了许多安全功能,Such作为机密容器,密钥管理,参考管理,远程测试,安全延迟,数据预处理和数据之后的数据,以保护使用中的AI数据的安全性。 [Xiangqiang Ruixuan GPU的CPU合作伙伴:AI多合一的合作伙伴已经开始在Great AI型号的当地机器中实施大量的2B和2C服务,此外,除了云服务外,还具有更多的应用程序方案。在这方面,英特尔不仅具有CPU Xeon处理器,而且具有独特的特征。两个合作伙伴是智能的形式,这是一台机器,全部在Superio Computer Sciencea之一中,极大地提高了当地私有化推论的效率,并鼓励了业务和业务应用程序的创新。特别是,DeepSeek领导的开源模型的支持大大降低了AI中的所有人的技术阈值,这在很大程度上鼓励了加速采用。通常,机器或典型的Intel AI AI工作使用Xeon CPU,并且与1-4 Ruixuan GPU结合使用。其中,GPU可以选择启动的Ruixuan A770 16GB,以及新推出的Ruixuan Pro B60 24GB。我相信每个人都听说过AI应用程序中的视频记忆需求。大型视频内存可以显着改善AI应用程序和规模应用程序场景的性能,包括具有较大参数尺度,上下文长度和更多同意的较大模型支持。 Lanzar在台北计算机展上的Ruixuan Pro B60端,许多合作伙伴已经推出了各种产品解决方案。例如,Asus,Asus,Blue Ji,Mingxuan,Hanyu和骄傲的Turbo粉丝,Senao的开放式粉丝,Mingxuan创建了双GPU,提供多达48 GB的图形记忆。进行本地推断时,即使在量化之后,也通常很难处理具有大型参数的大型模型。例如,由INT8量化的DeepSeek-R1 32B蒸馏模型很容易被食用超过32 GB的视频记忆。它单个图形卡如何增加视频的内存都没有关系,空间并不是无限的。因此,毫无疑问,多张卡的并行性是理想的解决方案,并且由于众多开源软件的支持,多张卡的基础通信不再是问题。英特尔拥有自己的多-T通信库库库莎丽特。 4件Ruixuan A770可以提供64 GB的平行视频存储器,实质上是执行完整的32B型号或量化的型号70B。四个Ruixuan Pro B60并行,最多具有96 GB的视频内存,这使得在大型模型中本地运行变得更加容易。有了足够大的视频内存,企业提供了灵活性来配置AI应用程序所需的上下文或并发扩展。过去的单个上下文的长度在过去只有10k,但现在32K非常普遍。许多大型型号已经实现了数百个K或1M,对视频记忆容量的需求是Al因此迅速增加。这四张卡可以并行实现出色的96 GB视频记忆。这很容易填充,例如同时分析数百个文件信息页面。当固定上下文长度相似时,同时扩展。随着每个会话产生大量的KV缓存和历史记录,视频内存需求会大大增加,并且卡甚至无法处理33 GB的大尺寸。模型中的单个同时性和四个字母可以同时满足50个同时性的实例。总而言之,在新的AI时代,GPU加速器不仅引起了很多关注,而且还吸引了公司投资方法。但是,作为计算机系统的指挥中心,CPU处理器的重要性不仅减少了,而且越来越突出。您还必须仔细选择和优化以释放AI加速度系统的全部力量。自成立以来,Xeon 6系列已考虑到加速AI应用程序的优化。无论是云还是地方,都为该行业带来了新的活力,从而实现了新的会变和能源效率。特别是,新的产量和能源效率核的设计以及诸如MRDIMM内存和AMX加速器改进之类的独家支持,都为Xeon 6带来了广泛的应用空间。随着Intel行业的广泛和广泛的合作,Xeon 6的各种客观设计的各种客观设计都可以满足云层的需求。 [本文的结尾]如果您需要重印,请务必向我们展示其来源:Kuai技术编辑:Shangfang Wenq